Elaborar um arcabouço regulatório para o uso de inteligência artificial (IA) no Brasil é um desafio complexo. Afinal, diversos aspectos devem ser levados em consideração como, por exemplo, desenvolvimento, tecnologia, ética, proteção de dados, proteção ao trabalho, níveis de risco, uso indevido de imagem, voz, notícias falsas etc.

Se, por um lado, os senadores que integram a Comissão Temporária sobre Inteligência Artificial (CTIA) no Senado, já adiaram por três vezes a votação do Projeto de Lei (PL) 2.338/2023, relatado pelo senador Eduardo Gomes (PL-TO), por outro, pesquisadores de todo o país tem enviado sugestões para ampliar o debate sobre o tema.

Uma destas contribuições foi elaborada por duas organizações vinculadas à PUCRS: a Artificial Intelligence Robotics Ethics Society (AIRES) e o Programa de Pós-Graduação em Direito (PPGD). Composta por 11 tópicos, a Nota Técnica visa auxiliar no desenvolvimento ético e seguro da IA, a fim de evitar distorções nos resultados esperados e a consequente responsabilização dos envolvidos. O documento aborda os seguintes assuntos: redação para definição do escopo da lei; criação de um conceito de “IA”; redação para criação de objetivos para IA no Brasil; redação para os fundamentos da IA; princípios norteadores para IA; diretrizes para o poder público ao disciplinar a IA no Brasil; diretrizes para a atuação do poder público ao utilizar IA; diretrizes para atuação do poder público; delimitação de competência; vigência; regras expressas e proibições.

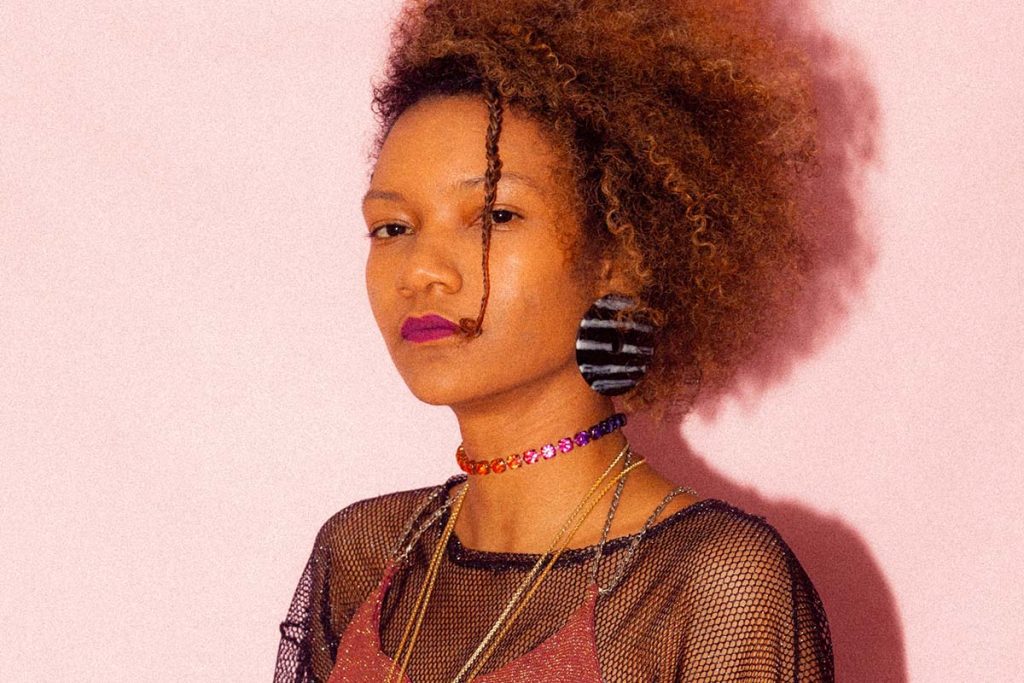

Uma das colaboradoras da ação, a pesquisadora da Rede de Inteligência Artificial Ética e Segura – Raies, Aline Santos Barbosa, destaca que algumas das sugestões foram adicionadas ao projeto substitutivo. Porém, questões como o impacto social ainda não estão bem claras. “Quando vemos sistemas, o final é sempre um resultado quantitativo. É um valor de acurácia ou um valor financeiro. Não está sendo mensurado o impacto social”.

Inspiração internacional

A proposta de legislação foi construída em sintonia com regulamentos já existentes nos Estados Unidos e Europa (EU AI Act). Aline entende que é complexo adaptar uma legislação estrangeira para o Brasil, uma vez que a sociedade brasileira possui características e particularidades próprias. Entretanto, a pesquisadora vê o modelo americano como mais preventivo do que mitigador. “Ao mesmo tempo, precisamos buscar equilíbrio econômico entre o quanto eu posso abrir de possibilidades para uma empresa de software, por exemplo”.

Pontos de atenção

Os artigos 10, 13 e 42 são vistos com certa preocupação pelos pesquisadores da PUCRS, Aires e do Projeto Raies. Para Aline, o artigo 10 transfere a responsabilidade para o usuário. “As apresentações falam de um Sistema Autônomo Inteligente, mas eles não mostram um sistema. Eu sei o sistema da Indústria Criativa, da produção alimentar, mas eu não sei o sistema de desenvolvimento de um sistema autônomo. Então, como é que eu vou conseguir dizer onde é que tem? Onde é que eu posso interferir e dizer, se eu não sei como o sistema funciona?”, questiona.

Além disso, Aline destaca que não há como fazer a concepção de um sistema sem levar em conta a diversidade. “Se eu tenho várias pessoas, que nasceram nas mesmas circunstâncias, pensando um sistema, elas vão pensar muito parecido ou da mesma forma. Então, eu não vou ter o ponto de vista da sociedade. Eu vou ter o ponto de vista de uma parte da sociedade, que vai determinar toda a tomada de decisão daquele sistema. Como é que vai ser democrático, se não utiliza dados diversos? Se perde a questão de democracia dentro da própria coleta e filtragem dos dados”.

Confira abaixo o texto do artigo 10:

- Art. 10. Quando a decisão, previsão ou recomendação de sistema de inteligência artificial produzir efeitos jurídicos relevantes ou que impactem de maneira significativa os interesses da pessoa, inclusive por meio da geração de perfis e da realização de inferências, esta poderá solicitar a intervenção ou revisão humana.

Parágrafo único. A intervenção ou revisão humana não será exigida caso a sua implementação seja comprovadamente impossível, hipótese na qual o responsável pela operação do sistema de inteligência artificial implementará medidas alternativas eficazes, a fim de assegurar a reanálise da decisão contestada, levando em consideração os argumentos suscitados pela pessoa afetada, assim como a reparação de eventuais danos gerados.

O artigo 13 é um dos trechos mais polêmicos da proposta, uma vez que prevê a classificação dos sistemas de inteligência artificial de acordo com o grau de risco. Para Aline, é preciso estipular o que é risco, levando em consideração o contexto de sua aplicação. “Nos sistemas autônomos para saúde, por exemplo, talvez o viés racial não seja tão importante para a realização de uma cirurgia. Agora, quando se trata do plano de saúde de um paciente, desde o primeiro exame até a tomada de decisão, aí a racialidade importa. Então, como é que eu vou generalizar o critério? É preciso ter toda uma fundamentação do que é importante e como a IA vai ser treinada”.

Confira abaixo o texto do artigo 13:

- Art. 13. Previamente a sua colocação no mercado ou utilização em serviço, todo sistema de inteligência artificial passará por avaliação preliminar realizada pelo fornecedor para classificação de seu grau de risco, cujo registro considerará os critérios previstos neste capítulo.

§ 1º Os fornecedores de sistemas de inteligência artificial de propósito geral incluirão em sua avaliação preliminar as finalidades ou aplicações indicadas, nos termos do art. 17 desta lei.

§ 2º Haverá registro e documentação da avaliação preliminar realizada pelo fornecedor para fins de responsabilização e prestação de contas no caso de o sistema de inteligência artificial não ser classificado como de risco alto.

§ 3º A autoridade competente poderá determinar a reclassificação do sistema de inteligência artificial, mediante notificação prévia, bem como determinar a realização de avaliação de impacto algorítmico para instrução da investigação em curso.

§ 4º Se o resultado da reclassificação identificar o sistema de inteligência artificial como de alto risco, a realização de avaliação de impacto algorítmico e a adoção das demais medidas de governança previstas no Capítulo IV serão obrigatórias, sem prejuízo de eventuais penalidades em caso de avaliação preliminar fraudulenta, incompleta ou inverídica.

Aline chama atenção para a questão ética, especialmente no trecho do artigo 42 que prevê a ‘transformação’ de determinada arte. “Uma coisa é eu reproduzir uma arte e dizer advinda de, referência tal. Outra coisa, é a possibilidade de alterar e manipular ela de novo, com cada um manipulando da forma que quiser”.

Confira abaixo o texto do artigo 42:

- Art. 42. Não constitui ofensa a direitos autorais a utilização automatizada de obras, como extração, reprodução, armazenamento e transformação, em processos de mineração de dados e textos em sistemas de inteligência artificial, nas atividades feitas por organizações e instituições de pesquisa, de jornalismo e por museus, arquivos e bibliotecas, desde que: I – não tenha como objetivo a simples reprodução, exibição ou disseminação da obra original em si; II – o uso ocorra na medida necessária para o objetivo a ser alcançado; III – não prejudique de forma injustificada os interesses econômicos dos titulares; e IV – não concorra com a exploração normal das obras.

§ 1º Eventuais reproduções de obras para a atividade de mineração de dados serão mantidas em estritas condições de segurança, e apenas pelo tempo necessário para a realização da atividade ou para a finalidade específica de verificação dos resultados da pesquisa científica.

§ 2º Aplica-se o disposto no caput à atividade de mineração de dados e textos para outras atividades analíticas em sistemas de inteligência artificial, cumpridas as condições dos incisos do caput e do § 1º, desde que as atividades não comuniquem a obra ao público e que o acesso às obras tenha se dado de forma legítima.

§ 3º A atividade de mineração de textos e dados que envolva dados pessoais estará sujeita às disposições da Lei nº 13.709, de 14 de agosto de 2018 (Lei Geral de Proteção de Dados Pessoais).

Mutabilidade do autor

Segundo o artigo 5º da Constituição Federal Brasileira, todos são iguais perante a lei, sem distinção de qualquer natureza. Esse direito fundamental básico, garante a autonomia do ser humano em sociedade. Ao propor uma análise a partir do impacto social individual humano, em comunidades e em sociedade, Aline entende que o debate em torno da regulamentação do uso de IA no Brasil seria mais bem estabelecido. Para a pesquisadora, a concepção das ações humanas e a mutabilidade do autor são muito importantes. “A manipulação de dados em prol de alguém ou em prol de um benefício próprio deveria ser muito restringida. No momento que virtualizamos a existência, personificamos diversas versões nossas online. Que percepção é essa de si mesmo ou de mim que está sendo criada? Porque é para além de mim. Então, estão tomando decisões de uma constituição minha, de uma virtualização minha”.

Saiba mais sobre o Projeto Raies

Financiado pela Fundação de Amparo à Pesquisa do Estado do RS – Fapergs, o Projeto Raies está instalado no NAVI AI New Ventures, hub de ciência de dados e inteligência artificial liderado pelo Tecnopuc e pela Wisidea Ventures. A Raies foi criada a partir da intersecção de pesquisadores, empresas, universidades e instituições nacionais e internacionais, a fim de promover o desenvolvimento de uma inteligência artificial ética e segura.

Aline explica que a iniciativa conta com a participação de pesquisadores das áreas de computação, direito e filosofia. “O nosso objetivo final é criar um Manual de Boas Práticas para utilização da internet, porque no final das contas, se as nossas vidas forem virtualizadas, é preciso criar um modus cidadão para conviver online. O projeto aborda desde a ideação, passando pelo desenvolvimento, monitoramento e utilização dos consumidores com determinado sistema”.